L’ IA pour plus d’équité ? – 3 questions à Emmanuel Lagarde

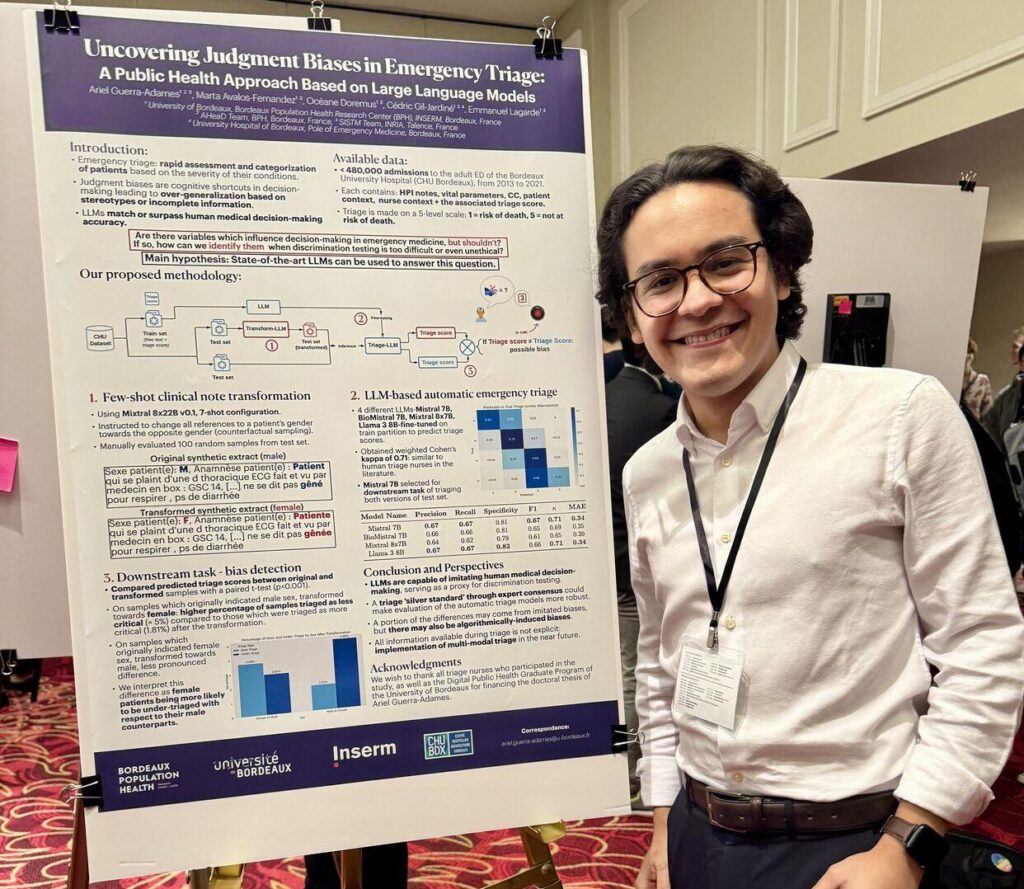

RetourAriel Guerra-Adames, Marta Avalos Fernandez et Emmanuel Lagarde pour les équipes AHeaD et SISTM du BPH, ont récemment mis au point un dispositif d’IA générative reproduisant les biais humains lors du triage aux urgences afin de mieux les identifier.

Ils ont mis en évidence que le sexe, même quand il n’a aucune pertinence pour le diagnostic, avait une influence sur le tri, entraînant une inégalité potentielle d’accès aux soins.

En effet, lorsque nous évaluons une situation pour prendre une décision rapide, notre cerveau peut parfois nous induire en erreur. Ces biais cognitifs nous sont inconscients et c’est pour cela qu’il importe de trouver des méthodes pour les identifier

Photo de pawel_czerwinski sur Unsplash

Quel est le point de départ qui a motivé ce sujet de recherche ?

Le sujet est d’actualité mais il est peu traité dans le contexte des urgences.

L’amélioration de la prise en charge, l’équité dans la prise en charge aux urgences et tout ce qui peut compromettre l’activité et la qualité du service, fait partie des objectifs de quelqu’un travaillant en santé publique.

Comment l’IA permet-elle d’analyser et de reproduire les biais cognitifs humains,

quelles sont les limites de cette expérimentation ?

En fait, l’IA est utilisée comme un modèle expérimental numérique, c’est un peu notre cobaye numérique.

Plutôt que de mener des expériences avec des infirmiers et infirmières en chair et en os, nous avons créé un modèle informatique qui simule le processus de décision de ces professionnels de santé ; Ce modèle est ensuite confronté à différentes situations pour voir comment il réagit.

Pour obtenir une machine qui prédit le niveau de tri exactement comme le ferait un infirmier, y compris avec ses biais cognitifs, qui peuvent être en partie liés à son ancienneté, son âge, son expérience, on a rassemblé et structuré un large jeu de données issus des dossiers patients des urgences.

Le résultat est un modèle qui se comporte de manière semblable à un humain.

Dans la phase suivante de l’étude, on a soumis à ce modèle les mêmes dossiers médicaux dont on avait modifié le genre du patient.

Les modifications du niveau de tri prédit témoignent de ce biais cognitif lié au genre du patient.

L’étape suivante, c’est l’utilisation du système pour atténuer ces biais.

Pouvoir évaluer ces biais de manière originale et très puissante avec un outil unique et inédit, sans avoir besoin de mettre en place des tests en condition réelle, permet de minimiser les contraintes expérimentales.

La réponse des infirmiers (du service d’urgence qui collabore régulièrement avec l’équipe AHeaD) à ce dispositif est très positive.

Où en est le dispositif d’IA générative, quand et comment sera-t-il utilisé,

et peut-il permettre de réduire d’autres biais dans le système de santé ?

Dans un premier temps, l’objectif est d’en faire un outil d’accompagnement et d’aide au tri pour les IOA (Infirmiers Organisateurs de l’Accueil aux urgences).

Le personnel des urgences pourrait, par exemple, disposer d’un outil proposant un tri à partir du dossier médical.

On peut imaginer bien d’autres secteurs d’applications pour ce dispositif, comme les ressources humaines, la notation des élèves et, de façon générale, tout processus incluant une décision ayant des conséquences importantes pour les gens.

En fait, il peut être utilisé chaque fois qu’une décision doit être prise et que certaines variables, ne devant pas entrer en compte, risquent d’influencer cette décision.

La seule condition pour permettre de développer une IA comme celle-ci est d’être en capacité de recueillir des données pouvant être « maquillées ».

Pour le système de santé on peut imaginer se servir de cet outil à chaque fois qu’il faut établir des priorités et un ordre de passage, pour des interventions par exemple. Mais aussi pour les attributions d’ALD (Affection Longue Durée), ou encore d’ITT (Incapacité Totale de Travail) dans les dossiers d’agression par exemple, qui ont des conséquences juridiques importantes pour les victimes mais aussi pour les auteurs.

Ce projet se poursuivra grâce à Ariel Guerra-Adames, qui a démarré une thèse en 2024, sous la direction de Marta Avalos et moi-même. L’objectif est d’analyser si les origines ethniques des patients ont une influence sur leur prise en charge aux urgences. Cette deuxième étude sera conduite à partir de données américaines

Pour conclure, ce projet est à notre sens une nouvelle arme pour améliorer l’équité dans notre système social en général.

Ariel Guerra-Adames remporte le prix du meilleur article sur le volet Impact et société du symposium Machine Learning for Health (ML4H) 2024, pour l’article « Uncovering Judgment Biases in Emergency Triage : A Public Health Approach Based on Large Language Models »